Tartalom

K:

Miért gyakran nehéz a mesterségesen visszatérő ideghálókat kiképzni?

A:

A mesterségesen visszatérő ideghálózatok kiképzésének nehézsége a komplexitásukkal függ össze.

Az egyik legegyszerűbb módszer annak magyarázatára, hogy miért nehéz a visszatérő ideghálózatokat kiképezni, az, hogy nem visszatérő ideghálózatok.

Az előremenő neurális hálózatokban a jelek csak egyirányban mozognak. A jel egy bemeneti rétegről különféle rejtett rétegekre mozog, és továbblép a rendszer kimeneti rétegére.

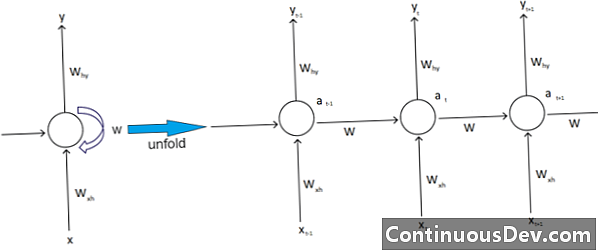

Ezzel szemben a visszatérő ideghálózatok és más típusú ideghálózatok bonyolultabb jelmozgással rendelkeznek. „Visszacsatolásos” hálózatoknak tekintve a visszatérő ideghálózatoknak előre és hátra egyaránt lehet jeleik, és tartalmazhatnak különböző „hurkokat” a hálózatban, ahol a számok vagy értékek visszakerülnek a hálózatba. A szakértők ezt az emlékezetükhöz kapcsolódó ismétlődő ideghálózatok aspektusával társítják.

Ezenkívül a komplexitás másik típusa ismétlődő ideghálózatokat érinti. Ennek egyik kiváló példája a természetes nyelvfeldolgozás.

A kifinomult természetes nyelvfeldolgozás során a neurális hálózatnak képesnek kell lennie arra, hogy emlékezzen a dolgokra. Bemenetekre is be kell számolni. Tegyük fel, hogy van egy program, amely egy szót elemezni akar vagy megjósolni szeretne más szavak mondatában. Lehet például egy rögzített ötszó hosszúság a rendszer számára, amelyet ki kell értékelni. Ez azt jelenti, hogy az ideghálózatnak bemenetekkel kell rendelkeznie ezekhez a szavakhoz, valamint képesnek kell lennie arra, hogy „emlékezzen” vagy edzjen e szavakkal. Ezen és más hasonló okok miatt a visszatérő ideghálózatok általában tartalmazzák ezeket a kevés rejtett hurkokat és visszajelzéseket a rendszerben.

A szakértők sajnálják, hogy ezek a komplikációk megnehezítik a hálózatok kiképzését. Az egyik leggyakoribb módszer ennek magyarázatára a robbanó és eltűnő gradiens probléma idézése. Alapvetõen a hálózat súlya akár robbant vagy eltûnik az értékeknél, nagy számú áthaladással.

A neurális hálózat úttörője, Geoff Hinton azzal magyarázza ezt a jelenséget az interneten, hogy a visszafelé irányuló lineáris áthaladás esetén a kisebb súlyok exponenciálisan csökkennek és a nagyobb súlyok felrobbannak.

Ez a probléma - folytatja - hosszú szekvenciákkal és sokkal több idő lépéssel tovább súlyosbodik, amelyekben a jelek növekednek vagy romlanak. A súlyos inicializálás segíthet, de ezeket a kihívásokat beépítik a visszatérő ideghálózati modellbe. Mindig ez lesz a kérdés, amely a saját tervezésükhöz és építésükhöz kapcsolódik. Lényegében a neurális hálózatok néhány bonyolultabb típusa valójában meghiúsítja képességünket, hogy könnyen kezeljük azokat. Gyakorlatilag végtelen mennyiségű összetettséget tudunk létrehozni, de gyakran látjuk, hogy növekednek a kiszámíthatóság és a skálázhatóság kihívásai.