Tartalom

- A nagy adatok nem strukturáltak vagy félig strukturáltak

- Nincs értelme a nagy adatok tárolására, ha nem tudjuk feldolgozni

- Hogyan oldja meg a Hadoop a nagy adatproblémát

- A Hadoop üzleti példája

Elvitel:

A Hadoop segíthet megoldani néhány nagy adat-kihívást.

A nagy adatok ... nos ... nagyak! Pontosan nem világos, hogy pontosan mekkora adatot lehet nagy adatként besorolni, tehát ne kerüljünk bele ebbe a vitába. Egy kisvállalat számára, amely szokott adatgyűjtéssel foglalkozni gigabájtban, 10 TB adat lenne BIG. Azonban a cégeknél, mint például a Yahoo, a petabájt nagy.Csak a nagy adatmennyiség miatt lehetetlenné válik (vagy legalábbis megfizethetetlennek tartja) a hagyományos tárolókban, például adatbázisokban vagy a hagyományos iratrendezőkben való tárolása. A gigabájt adattárolás költségeiről beszélünk. A hagyományos adattároló használata sok pénzbe kerülhet a nagy adatok tárolására.

Itt is vessen egy pillantást a nagy adatokra, azok kihívásaira és arra, hogy a Hadoop miként segíthet megoldani őket.Először is, a big data legnagyobb kihívás.

A nagy adatok nem strukturáltak vagy félig strukturáltak

Sok nagy adat nincs strukturálva. Például a kattintásfolyam-napló adatai a következőképpen nézhetnek ki:időbélyeg, felhasználói_azonosító, oldal, hivatkozási oldal

A struktúra hiánya miatt a relációs adatbázisok nem alkalmasak a nagy adatok tárolására. Ráadásul nem sok adatbázis képes kezelni milliárd adatsor tárolását.

Nincs értelme a nagy adatok tárolására, ha nem tudjuk feldolgozni

A nagy adatok tárolása a játék része. Feldolgoznunk kell az intelligencia bányászatához. A hagyományos tárolórendszerek elég "hülye" abban az értelemben, hogy csak biteket tárolnak. Nem kínálnak semmilyen feldolgozási teljesítményt.A hagyományos adatfeldolgozási modell adatait tárolófürtben tárolja, amelyet feldolgozási célra átmásolnak egy számítási fürtre. Az eredményeket visszaírják a tárolófürtbe.

Ez a modell azonban nem igazán működik a nagy adatokon, mert annyi adatnak a számítási fürtbe történő másolása túl időigényes vagy lehetetlen lehet. Szóval mi a válasz?

Az egyik megoldás a nagy adatok helyben történő feldolgozása, például egy adattároló fürtként megduplázódó tárolófürtben.

Tehát, amint azt fentebb láttuk, a nagy adatok meghiúsítják a hagyományos tárolást. Tehát hogyan kezeljük a nagy adatokat?

Hogyan oldja meg a Hadoop a nagy adatproblémát

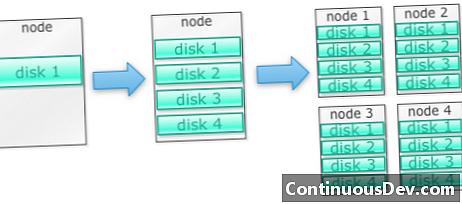

A Hadoop úgy lett felépítve, hogy egy gépcsoporton futjonKezdjük egy példával. Mondjuk, hogy sok fényképet kell tárolnunk. Egyetlen lemezzel kezdjük. Ha túllépjük az egyetlen lemezt, használhatunk néhány lemezt, amely egy gépen van rakva. Amikor kinyomtatjuk az összes lemezt egyetlen gépen, akkor be kell szereznünk egy csomó gépet, mindegyik egy csomó lemezt.

Pontosan így épül fel a Hadoop. A Hadoop-ot úgy tervezték, hogy a gépeken egy futófelületen futhasson.

A Hadoop klaszterek vízszintesen méretezhetők

Több tároló és számítási teljesítmény érhető el, ha több csomópontot hozzáad egy Hadoop-fürthez. Ez kiküszöböli annak szükségességét, hogy egyre erősebb és drágább hardvert vásároljanak.

A Hadoop nem strukturált / félig strukturált adatokat képes kezelni

A Hadoop nem hajt végre sémát az általa tárolt adatokra. Tetszőleges és bináris adatokat képes kezelni. A Hadoop tehát bármilyen strukturálatlan adatot könnyen emészthet.

A Hadoop fürtök tárolást és számítástechnikát biztosítanak

Láttuk, hogy a különálló tároló és feldolgozó fürtök nem a legmegfelelőbbek a nagy adatokhoz. A Hadoop fürtök azonban tárolást és elosztott számítástechnikát biztosítanak egyben.

A Hadoop üzleti példája

A Hadoop elfogadható költségekkel tárolja a nagy adatokat

A nagy adatok hagyományos tárolással történő tárolása költséges lehet. A Hadoop az alapanyagok köré épül, tehát meglehetősen nagy tárhelyet kínál ésszerű költségekkel. A Hadoop-ot petabájt méretű területen használták.

Egy Cloudera egyik tanulmánya szerint a vállalkozások általában kb. 25 000–50 000 dollárt költenek terabyte / év-re. A Hadoop esetében ez a költség néhány ezer dollárra esik terabyte / év. Ahogy a hardver egyre olcsóbb, ez a költség tovább csökken.

A Hadoop lehetővé teszi új vagy több adat rögzítését

Időnként a szervezetek nem vesznek fel bizonyos típusú adatokat, mert azok tárolása túl költséges volt. Mivel a Hadoop elfogadható költségekkel rendelkezik tárolással, az ilyen típusú adatok rögzíthetők és tárolhatók.

Példa erre a webhely kattintási naplói. Mivel ezeknek a naplóknak a mennyisége nagyon magas lehet, nem sok szervezet rögzítette ezeket. A Hadoop segítségével most már rögzíteni és tárolni lehet a naplókat.

A Hadoop segítségével hosszabb ideig tárolhatja az adatokat

A tárolt adatok mennyiségének kezelése érdekében a vállalatok rendszeresen törlik a régebbi adatokat. Például csak az elmúlt három hónap naplóit lehetett tárolni, míg a régebbi naplókat törölték. A Hadoop segítségével hosszabb ideig lehet tárolni a történeti adatokat. Ez lehetővé teszi új elemzéseket a régebbi történelmi adatokkal kapcsolatban.

Vegyen például kattintási naplókat egy webhelyről. Néhány évvel ezelőtt ezeket a naplókat egy rövid ideig tárolták a statisztikák, például a népszerű oldalak kiszámításához. Most a Hadoop esetén életképes ezeket a kattintási naplókat hosszabb ideig tárolni.

A Hadoop méretezhető elemzést nyújt

Nincs értelme ezeket az adatokat tárolni, ha nem tudjuk elemezni azokat. A Hadoop nem csak elosztott tárolást, hanem elosztott feldolgozást is biztosít, ami azt jelenti, hogy nagy mennyiségű adatot tudunk párhuzamosan összenyomni. A Hadoop számított keretét MapReduce-nek hívják. A MapReduce bebizonyosodott a petabájt méretarányban.

A Hadoop gazdag elemzést nyújt

A natív MapReduce elsődleges programozási nyelvként a Java támogatja. Más nyelvek, például a Ruby, a Python és az R is használhatók.

Természetesen az egyedi MapReduce kód írása nem az egyetlen módszer az adatok elemzésére a Hadoopban. Magasabb szintű térképcsökkentés érhető el. Például egy Pig nevű eszköz angolul ismeri el az adatfolyam nyelvét, és lefordítja azokat MapReduce-ba. Egy másik eszköz, a Hive, az SQL lekérdezéseket veszi és futtatja azokat a MapReduce segítségével.

Az üzleti intelligencia (BI) eszközök még magasabb szintű elemzést nyújthatnak. Vannak eszközök az ilyen típusú elemzésekhez is.

Ez a tartalom Mark Kerzner és Sujee Maniyam "Hadoop Illuminated" című részéből származik. A Creative Commons Nevezd meg! Nem-kereskedelmi-ShareAlike 3.0 Unported licencet.