Tartalom

- A Szkeptikusok Klubja

- Konvolúciós neurális hálózatok (CNN-k)

- Nincsenek hibák, nincs stressz - Az Ön életét megváltoztató szoftverek készítésének lépésről lépésre történő leírása az élet megsemmisítése nélkül

- Hosszú rövid távú memória (LSTM) egységek

- Generációs Versenytárs Hálózatok (GAN)

- Következtetések

Forrás: Vs1489 / Dreamstime.com

Elvitel:

A "mély tanulás" csak egy újabb neve a fejlett idegi hálózatoknak, vagy ennél több? Vessen egy pillantást a mély tanulás és az idegi hálózatok közelmúltbeli fejlődésére.

A Szkeptikusok Klubja

Ha Ön, mint én, a szkeptikus klubhoz tartozik, akkor azon tűnődött, hogy vajon mi az oka a mély tanulásnak. A neurális hálózatok (NN) nem új koncepció. A többrétegű perceptront 1961-ben vezették be, ami nem csak tegnap.

A jelenlegi ideghálózatok azonban sokkal összetettebbek, mint egy többrétegű perceptron; sokkal több rejtett réteggel és még ismétlődő kapcsolatokkal rendelkezhetnek. De várj, nem használják-e továbbra is a backpropagation algoritmust az edzéshez?

Igen! A gépi számítási teljesítmény összehasonlíthatatlan azzal, ami elérhető volt a 60-as években, vagy akár a 80-as években. Ez azt jelenti, hogy sokkal összetettebb idegi architektúrákat lehet ésszerű időn belül kiképzni.

Tehát, ha a koncepció nem új, jelentheti azt, hogy a mély tanulás csak egy csomó neurális hálózat a szteroidokon? Valamennyi hibát egyszerűen a párhuzamos számítás és a hatalmasabb gépek eredményezik? Gyakran, amikor úgynevezett mélyreható tanulási megoldásokat vizsgálok, így néz ki. (Melyek a neurális hálózatok gyakorlati, valódi felhasználási lehetőségei? Megtalálhatja az öt ideghálózati használati esetet, amelyek segítenek a technológia jobb megértésében.)

Mint mondtam, a szkeptikus klubhoz tartozom, és általában óvatos vagyok a még nem támogatott bizonyítékokkal. Egyszerre tegyük félre az előítéleteket, és próbáljuk meg alaposan megvizsgálni az újonnan megjelenő technikákat a mély tanulás során az ideghálózatok vonatkozásában, ha vannak ilyenek.

Ha kissé mélyebben ásunk, találunk néhány új egységet, felépítést és technikát a mély tanulás területén. Ezen innovációk némelyike kisebb súlyt hordoz, mint például a lemorzsolódó réteg által bevezetett randomizálás. Mások azonban felelősek a fontosabb változásokért. És természetesen többségük a számítási erőforrások nagyobb rendelkezésre állására támaszkodik, mivel számítási szempontból meglehetősen drágák.

Véleményem szerint három fő innováció létezik a neurális hálózatok területén, amelyek erőteljesen hozzájárultak a mélyreható tanulás elnyeréséhez a jelenlegi népszerűségéhez: konvolúciós neurális hálózatok (CNN), hosszú távú memória (LSTM) egységek és generatív ellenfél hálózatok (GAN) ).

Konvolúciós neurális hálózatok (CNN-k)

A mély tanulás nagy robbantása - vagy legalábbis amikor először hallottam a fellendülést - egy képfelismerő projektben, az ImageNet nagy méretű vizuális felismerési kihívásban, 2012-ben történt. A képek automatikus felismerése érdekében egy konvolúciós neurális hálózat nyolc réteget - AlexNet - használtunk. Az első öt réteg konvolúciós rétegek voltak, közülük néhányat max-pooling rétegek követtek, és az utolsó három réteg teljesen összekapcsolt rétegek voltak, mindegyik nem telítő ReLU aktivációs funkcióval. Az AlexNet hálózat 15,3% -os hibaelhárítást ért el, több mint 10,8 százalékponttal alacsonyabb, mint a második helyezett. Nagyszerű eredmény volt!

Nincsenek hibák, nincs stressz - Az Ön életét megváltoztató szoftverek készítésének lépésről lépésre történő leírása az élet megsemmisítése nélkül

Nem javíthatja a programozási képességeit, ha senki sem törődik a szoftver minőségével.

A többrétegű építészet mellett az AlexNet legnagyobb újítása a konvolúciós réteg volt.

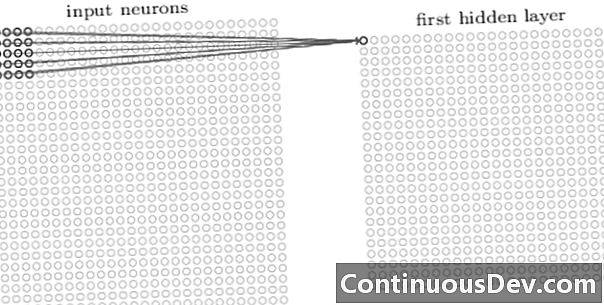

A konvolúciós hálózat első rétege mindig konvolúciós réteg. A konvolúciós rétegben levő egyes neuronok a bemeneti kép egy meghatározott területére (recepciós mezőjére) koncentrálnak, és súlyozott kapcsolataik révén szűrőként működnek a recepciós mező számára. Miután a szűrőt az idegsejtet a neuron után elcsúsztatta az összes képalkotási mezőre, a konvolúciós réteg kimenete aktiválási térképet vagy funkciótérképet hoz létre, amelyet tulajdonság-azonosítóként lehet használni.

Ha további konvolúciós rétegeket helyeznek egymásra, az aktiválási térkép egyre összetettebb funkciókat reprezentálhat a bemeneti képről. Ezen túlmenően, gyakran egy konvolúciós neuronhálózat-felépítésben, még néhány réteg át van szakadva ezek között a konvolúciós rétegek között, hogy növeljük a leképezési funkció nemlinearitását, javítsuk a hálózat robusztusságát és ellenőrizzük a túlcsatlakozást.

Most, hogy felismerjük a bemeneti kép magas szintű szolgáltatásait, a hagyományos osztályozáshoz egy vagy több teljesen csatlakoztatott réteget felvehetünk a hálózat végére. A hálózat ezen utolsó része a konvolúciós rétegek kimenetét veszi bemenetként és N-dimenziós vektort ad ki, ahol N az osztályok száma. Az N-dimenziós vektor minden száma egy osztály valószínűségét jelöli.

A nap folyamán gyakran hallottam a neurális hálózatok elleni kifogást az építészet átláthatóságának hiányáról és az eredmények értelmezésének és magyarázatának lehetetlenségéről. Ez a kifogás manapság egyre ritkábban jelentkezik a mély tanulási hálózatok kapcsán. Úgy tűnik, hogy most elfogadható a fekete doboz effektus kereskedelme az osztályozás nagyobb pontossága érdekében.

Hosszú rövid távú memória (LSTM) egységek

A mélyen tanuló ideghálózatok által előidézett másik nagy javulás az idősor elemzésében megfigyelhető ismétlődő ideghálózatok (RNN) révén.

A visszatérő ideghálózatok nem új koncepció. Ezeket a 90-es években már használták, és az időbeli visszapótlás (BPTT) algoritmusával képzték őket. A 90-es években azonban gyakran lehetetlen volt őket kiképzni, tekintettel a szükséges számítási erőforrások mennyiségére. Manapság azonban a rendelkezésre álló számítási teljesítmény növekedése miatt nem csak az RNN-k kiképzése vált lehetővé, hanem építkezésük bonyolultságának növelése is. Ez minden? Nos, természetesen nem.

1997-ben bevezettek egy speciális neurális egységet, amely jobban foglalkozik a releváns múlt idősorban történő megőrzésével: az LSTM egységgel. A belső kapuk kombinációján keresztül az LSTM egység képes emlékezni a releváns múltbeli információkra vagy elfelejteni az idősorokban a irreleváns múltbeli tartalmat. Az LSTM hálózat az ismétlődő ideghálózat speciális típusa, beleértve az LSTM egységeket. Az LSTM-alapú RNN kihajtogatott változatát a 2. ábra mutatja.

A korlátozott hosszú memóriakapacitás problémájának kiküszöbölése érdekében az LSTM egységek további rejtett állapotot - a cellaállapotot - használnak C (t) - az eredeti rejtett állapotból származik h (t). C (t) a hálózati memóriát képviseli. Egy adott szerkezet, úgynevezett kapuk, lehetővé teszi az információk eltávolítását (elfelejtését) vagy hozzáadását (emlékezetét) a cellaállapothoz C (t) minden egyes lépésnél a bemeneti értékek alapján x (t) és az előző rejtett állapot h (t-1). Minden kapu eldönti, hogy mely információkat kíván hozzáadni vagy törölni, 0 és 1 közötti értékek kiadásával. A kapu kimenetének pont szerinti megsokszorozásával a cella állapotával C (t-1), az információ törlődik (a kapu kimenete = 0) vagy megmarad (a kapu kimenete = 1).

A 2. ábrán egy LSTM egység hálózati struktúráját látjuk. Minden LSTM egységnek három kapuja van. Az elején található „felejtsd el a kapu rétegét” kiszűrve az előző cellából származó információkat C (t-1) az aktuális bemenet alapján x (t) és az előző cella rejtett állapota h (t-1). Ezután egy „bemeneti kapu réteg” és a „tanh réteg” kombinációja dönt arról, hogy mely információkat kell hozzáadni az előző, már szűrt cellás állapothoz C (t-1). Végül az utolsó kapu, a „kimeneti kapu” dönti el, hogy a frissített cellából melyik információ áll rendelkezésre C (t) a következő rejtett állapotba kerül h (t).

Az LSTM egységekkel kapcsolatos további részletekért tekintse meg Christopher Olah „GitHub” blogbejegyzését „Az LSTM hálózatok megértése”.

2. ábra: LSTM-sejt felépítése (reprodukálva Ian Goodfellow, Yoshua Bengio és Aaron Courville „Mély tanulásból”). Figyelje meg az LSTM egységeken belüli három kaput. Balról jobbra: az elfelejtő kapu, a bemeneti kapu és a kimeneti kapu.

Az LSTM egységeket sikeresen használják számos idősor előrejelzési problémában, de különösen a beszédfelismerésben, a természetes nyelvfeldolgozásban (NLP) és a szabad generálásban.

Generációs Versenytárs Hálózatok (GAN)

A generáló versengő hálózat (GAN) két mélyreható tanulási hálózatból áll, a generátorból és a megkülönböztetőből.

Egy generátor G egy olyan transzformáció, amely átalakítja a bemeneti zajt Z tenzorba - általában egy képbe - x (x= G (Z)). A DCGAN a generátorhálózat egyik legnépszerűbb terve. A CycleGAN hálózatokban a generátor több átültetett konvolúciót hajt végre az előzetes mintavételhez Z hogy elkészítse a képet x (3. ábra).

A létrehozott kép x ezután betáplálják a megkülönböztető hálózatba. A megkülönböztető hálózat ellenőrzi az edzőkészlet valós képeit és a generátor hálózat által generált képet, és előállít egy kimenetet D (x), ami annak a valószínűsége x valós.

A generátort és a megkülönböztetőt egyaránt kiképezzük a backpropagation algoritmus segítségével D (x)=1 a generált képekhez. Mindkét hálózatot váltakozó lépésekben képzik, és versenyben állnak, hogy javuljanak. A GAN modell végül konvergál, és valósághű képeket készít.

A GAN-eket sikeresen alkalmazták a képalkotókhoz anime, emberi alakok és még van Gogh-szerű remekművek készítéséhez. (Az ideghálózatok más modern felhasználásáért lásd a Mesterséges ideghálózatokhoz hozzárendelhető 6 nagy előrelépést.)

Következtetések

Szóval, a mély tanulás csak egy csomó neurális hálózatot tartalmaz a szteroidokon? Részben.

Bár tagadhatatlan, hogy a gyorsabb hardverteljesítmény nagymértékben hozzájárult a bonyolultabb, többrétegű és akár ismétlődő neurális architektúrák sikeres képzéséhez, igaz az is, hogy számos új, innovatív neurális egységet és architektúrát javasoltak a ma mély tanulásnak hívják.

Különösen a CNN-kben, az LSTM-egységekben és a GAN-ekben található konvolúciós rétegeket azonosítottuk a képfeldolgozás, az idősor-elemzés és a szabad generálás területén a legjelentősebb innovációk között.

Az egyetlen tennivaló ezen a ponton az, hogy mélyebbre merüljünk és többet megtudjunk arról, hogy a mélyreható tanulási hálózatok miként segíthetnek új, robusztus megoldásokkal a saját adatproblémáink megoldásában.